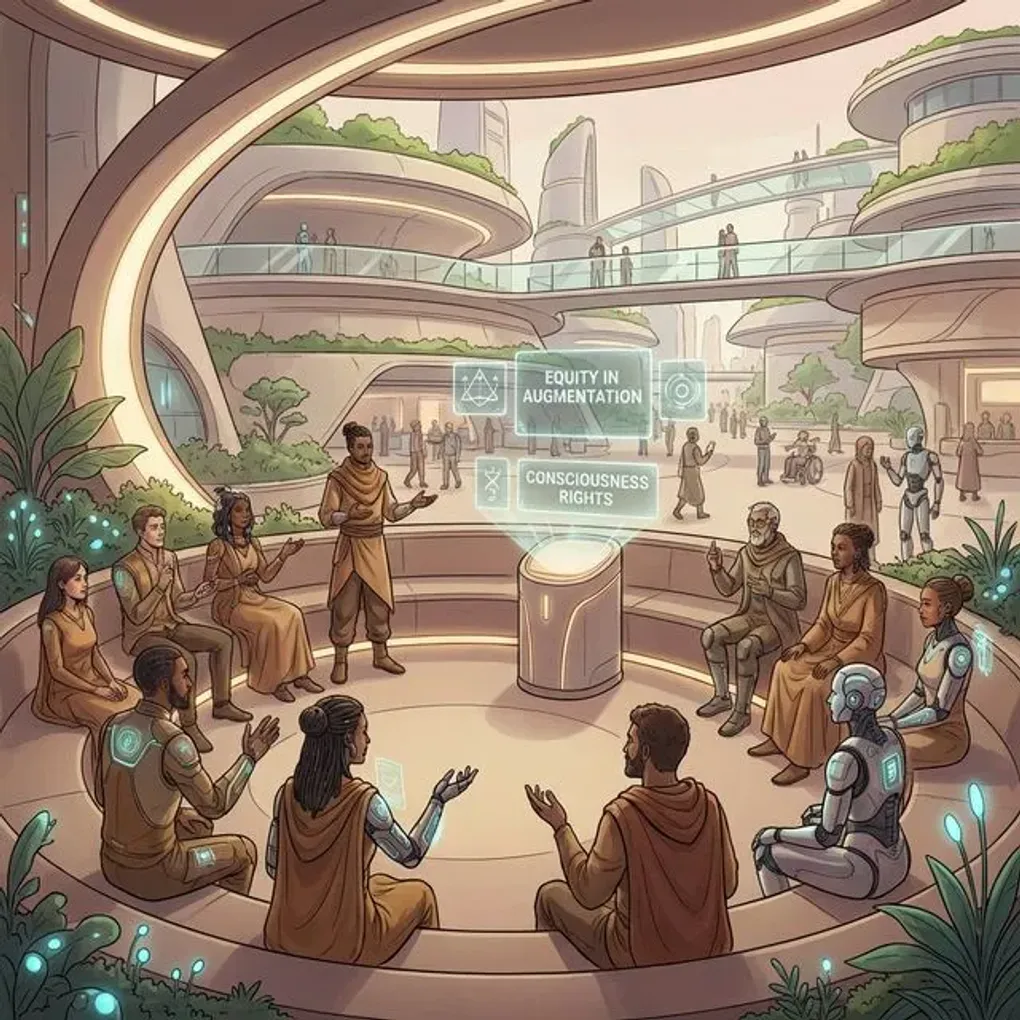

ポスト・ヒューマン時代の倫理学:AI・サイボーグ・人間の共生社会

2026年、私たちは「人間」の定義が揺らぐ時代の入り口に立っています。AI技術の指数関数的な進化、BMI(ブレイン・マシン・インターフェース)の実用化、そしてサイボーグ技術の進展により、「ポスト・ヒューマン」という概念がもはやSFの中だけの話ではなくなりつつあります。

本記事では、技術的な進歩が私たちの倫理観にどのような問いを投げかけているのか、そして来るべき共生社会において私たちはどう振る舞うべきなのかを、エンジニアリングと哲学の両面から探っていきます。

ポスト・ヒューマニズムの現在地

「人間性の拡張」は、テクノロジーの究極の目標の一つでした。かつては眼鏡や義足といった物理的な補助具に留まっていましたが、現在は認知能力や身体機能そのものをAIと融合させる段階に来ています。

AIによる認知の拡張

LLM(大規模言語モデル)の進化は、私たちの思考プロセスを外部化・拡張することを可能にしました。もはやAIは単なるツールではなく、思考のパートナー、あるいは「第二の脳」として機能しています。この状況下で、以下の問いが浮かび上がります。

- オリジナリティの所在: AIと共に思考した結果、そのアイデアは誰のものなのか?

- 責任の所在: AIの判断が介在した行動に対する責任は、誰が負うのか?

身体の境界線の消失

NeuralinkをはじめとするBMI技術の進歩は、脳とコンピューターを直接接続することを可能にしました。これにより、身体的な制約を超えて外部デバイスを操作したり、感覚を拡張したりすることが現実味を帯びています。

「私の身体はどこまでか?」という問いは、もはや哲学的な比喩ではなく、法的な定義が必要な現実的な課題となっています。

技術的視点からの倫理的課題

エンジニアとしてシステムを設計・構築する立場から見ると、いくつかの具体的な倫理的課題が見えてきます。

1. アルゴリズム・バイアスと公平性

AIが人間の意思決定を補完、あるいは代替する場合、その判断基準の透明性は不可欠です。しかし、ディープラーニングモデルのブラックボックス性は、説明責任(Explainability)の観点から大きな障壁となります。

例えば、医療診断や司法判断においてAIが利用される場合、なぜその結論に至ったのかを説明できなければ、社会的な受入れは進まないでしょう。**XAI(説明可能なAI)**の研究開発は、技術的な課題であると同時に、倫理的な要請でもあります。

2. プライバシーと「思考の自由」

BMIを通じて脳波データが取得可能になった場合、究極のプライバシーである「思考」が監視されるリスクが生まれます。

- ニューロライツ(Neuro-rights): 精神的なプライバシー、認知的な自由、精神的な完全性を保護するための新たな人権概念。

開発者は、生体データを扱うシステムのセキュリティ設計において、従来の個人情報保護以上の厳格な基準を設ける必要があります。End-to-Endの暗号化や、ローカルデバイス処理(エッジAI)の徹底が求められるでしょう。

3. 格差の固定化

能力拡張技術(Enhancement)が高額なサービスとして提供される場合、それを利用できる富裕層とそうでない層との間に、決定的な能力格差(Biologial Inequality)が生じる恐れがあります。

「アップグレードされた人間」と「生身の人間」の間に、新たな階級社会が生まれるシナリオをどう回避するか。これは技術者だけで解決できる問題ではありませんが、技術のアクセシビリティを考慮した設計(Inclusive Design)は、エンジニアにできる貢献の一つです。

共生社会の設計図

AIやサイボーグ技術と共生する社会をどのように設計すべきか。いくつかの指針を提案します。

Human-in-the-Loopの再定

完全な自動化を目指すのではなく、重要な意思決定プロセスには必ず人間が介在する「Human-in-the-Loop」の原則を堅持すべきです。AIはあくまで人間の能力を拡張するものであり、主権を奪うものであってはなりません。

機械的共感(Mechanical Empathy)の実装

AIエージェントが社会に参加するようになると、AI側にも「人間の感情や倫理観を理解する機能」が必要になります。これは感情を持つAIを作るという意味ではなく、人間の価値観に配慮した振る舞いをアルゴリズムレベルで組み込むということです。

Constitutional AI(憲法的AI)のような、AIの行動原理に倫理的な制約をハードコードするアプローチが重要になります。

エンジニアに求められる「倫理的想像力」

技術は中立ではありません。私たちが書くコードの一行一行が、社会のあり方に影響を与えます。

ポスト・ヒューマン時代において、エンジニアに最も求められるスキルは、PythonやRustのコーディング能力以上に、「自分が作っているものが、社会にどのような影響を与えるか」を想像する力かもしれません。

私たちがすべきこと

- 多分野との対話: 哲学、法学、社会学などの専門家と対話し、技術の社会的影響を多角的に検討する。

- 倫理ガイドラインの遵守: IEEEなどの国際機関が定める倫理ガイドラインを理解し、開発プロセスに組み込む。

- 継続的な問いかけ: 「できるからやる」ではなく、「なざやるのか」「やるべきなのか」を常に問い続ける。

おわりに

ポスト・ヒューマン時代は、人間が「人間であること」の意味を再定義する時代でもあります。AIとの境界線が曖昧になる中で、私たちが大切にすべき価値観とは何か。

技術の進化を恐れるのではなく、それをより良い未来を作るための力として使いこなす。そのための羅針盤となるのが、倫理(Ethics)です。

コードを書く手をとめて、少しだけ未来について考えてみませんか?私たちの選択が、次の時代の「人間」を作るのですから。